Recentemente, pesquisadores do Laboratório de Ciência da Computação e Inteligência Artificial do MIT (CSAIL) propuseram uma mudança simples no esquema de treinamento de difusão, tornando o processo de “desruído” de sequências muito mais flexível. Essa nova abordagem, chamada “Diffusion Forcing”, combina o melhor dos modelos de difusão e do método tradicional conhecido como “Teacher Forcing”, que divide a geração de sequências em etapas menores e mais gerenciáveis.

O Diffusion Forcing encontrou um ponto em comum entre os modelos de difusão e o Teacher Forcing: ambos utilizam esquemas de treinamento que envolvem prever tokens mascarados (ou com ruído) a partir de tokens não mascarados. No caso dos modelos de difusão, eles adicionam ruído gradualmente aos dados, o que pode ser visto como uma forma de mascaramento fracionário. A nova técnica do MIT ensina redes neurais a limpar uma coleção de tokens, removendo diferentes quantidades de ruído enquanto prevê os próximos tokens. O resultado? Um modelo de sequência flexível e confiável que gera vídeos artificiais de maior qualidade e melhora a tomada de decisões em robôs e agentes de IA.

Ao filtrar dados ruidosos e prever os próximos passos de uma tarefa, o Diffusion Forcing pode ajudar robôs a ignorar distrações visuais e completar tarefas de manipulação. Além disso, ele é capaz de gerar sequências de vídeo estáveis e consistentes, guiando um agente de IA por labirintos digitais. Essa técnica pode, potencialmente, permitir que robôs domésticos e industriais se adaptem a novas tarefas e aprimorem o entretenimento gerado por IA.

Boyuan Chen, estudante de doutorado em engenharia elétrica e ciência da computação no MIT e membro do CSAIL, explica que “os modelos de sequência visam se condicionar ao passado conhecido e prever o futuro desconhecido, um tipo de mascaramento binário. No entanto, o mascaramento não precisa ser binário.” Com o Diffusion Forcing, diferentes níveis de ruído são adicionados a cada token, funcionando como um tipo de mascaramento fracionário. Durante os testes, o sistema é capaz de “desmascarar” uma coleção de tokens e difundir uma sequência no futuro próximo com um nível de ruído menor, sabendo em quais dados confiar para superar entradas fora da distribuição.

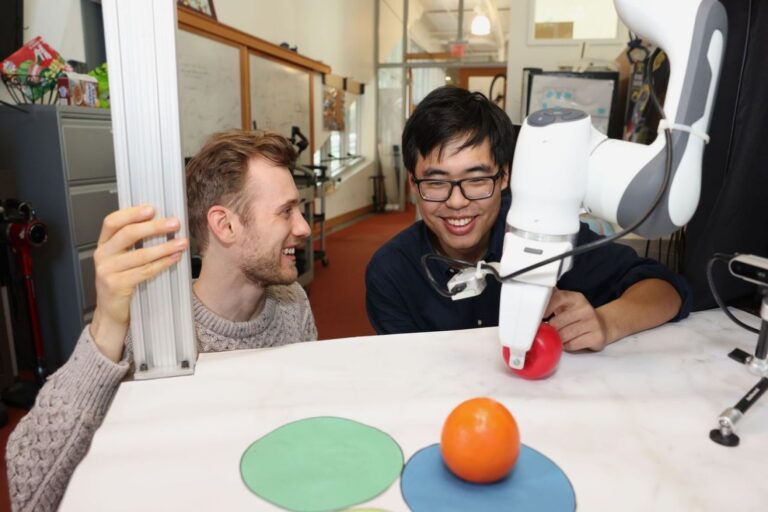

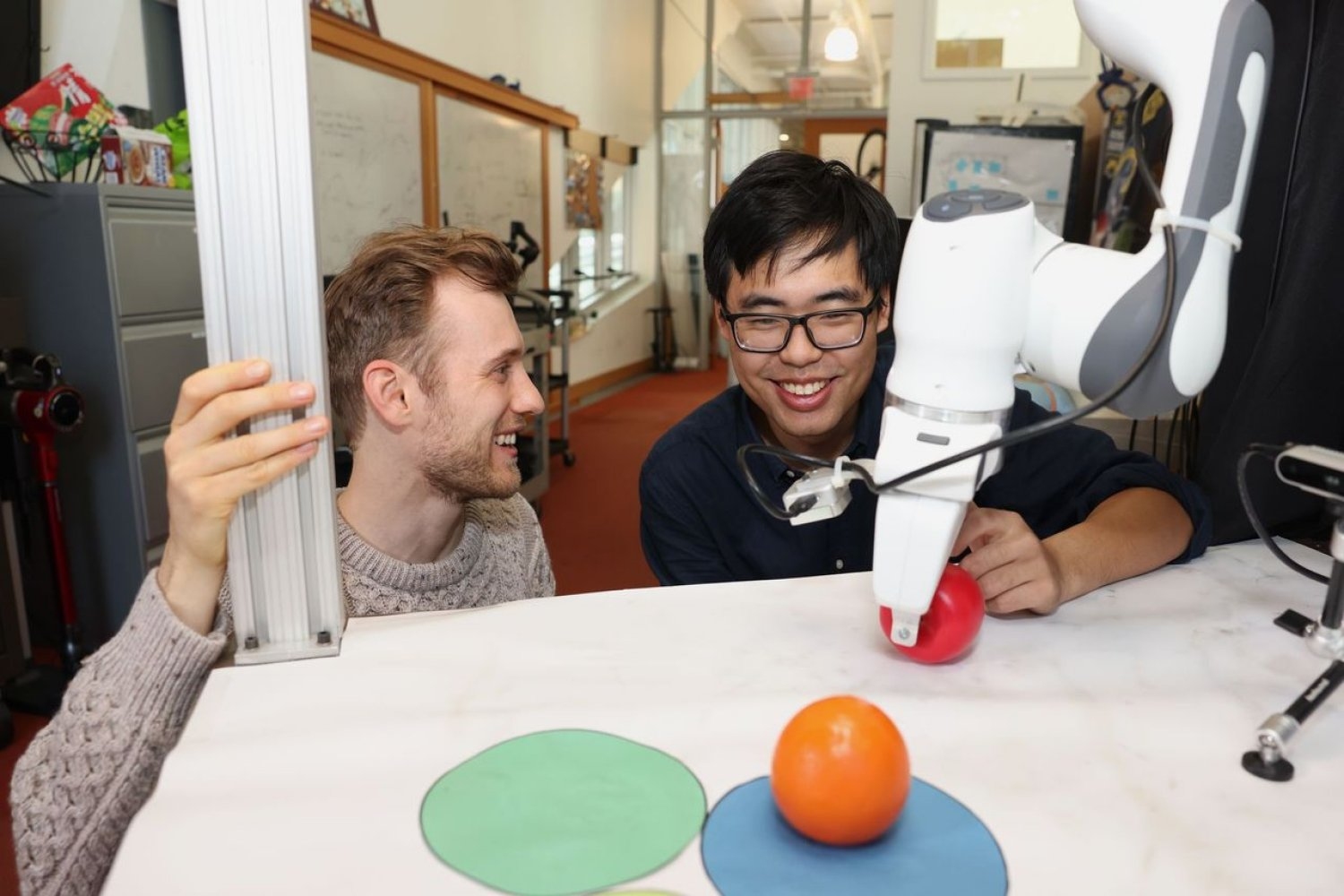

Em diversos experimentos, o Diffusion Forcing se destacou ao ignorar dados enganosos para executar tarefas enquanto antecipava ações futuras. Por exemplo, ao ser implementado em um braço robótico, ajudou a trocar duas frutas de brinquedo em três tapetes circulares, um exemplo simples de tarefas de longo prazo que exigem memória. Os pesquisadores treinaram o robô controlando-o à distância em uma realidade virtual, onde o robô imitava os movimentos do usuário a partir da câmera. Mesmo começando de posições aleatórias e enfrentando distrações, como uma sacola de compras bloqueando os marcadores, o robô conseguiu colocar os objetos em seus lugares-alvo.

Para gerar vídeos, o Diffusion Forcing foi treinado com jogadas do jogo “Minecraft” e ambientes digitais coloridos criados no simulador DeepMind Lab do Google. Quando recebeu um único quadro de filmagem, o método produziu vídeos mais estáveis e de maior resolução do que modelos comparáveis, como o modelo de difusão de sequência completa similar ao Sora e os modelos de previsão do próximo token semelhantes ao ChatGPT. Esses modelos anteriores geraram vídeos inconsistentes, com o último falhando em produzir vídeos funcionais além de 72 quadros.

Além de gerar vídeos impressionantes, o Diffusion Forcing também pode atuar como um planejador de movimento que orienta ações em direção a resultados desejados. Graças à sua flexibilidade, ele pode gerar planos com horizontes variados, realizar buscas em árvore e incorporar a intuição de que o futuro distante é mais incerto do que o futuro próximo. Em uma tarefa de resolução de labirinto 2D, o Diffusion Forcing superou seis modelos de referência, gerando planos mais rápidos em direção ao local desejado, indicando que pode ser um planejador eficaz para robôs no futuro.

Em cada demonstração, o Diffusion Forcing funcionou como um modelo de sequência completo, um modelo de previsão do próximo token ou ambos. Segundo Chen, essa abordagem versátil pode servir como uma base poderosa para um “modelo de mundo”, um sistema de IA capaz de simular a dinâmica do mundo treinando com bilhões de vídeos da internet. Isso permitiria que robôs realizassem tarefas novas imaginando o que precisam fazer com base em seu entorno. Por exemplo, se um robô fosse solicitado a abrir uma porta sem ter sido treinado para isso, o modelo poderia gerar um vídeo que mostrasse à máquina como proceder.

A equipe está atualmente buscando expandir seu método para conjuntos de dados maiores e os mais recentes modelos de transformadores, com o objetivo de aprimorar ainda mais o desempenho. Eles pretendem ampliar seu trabalho para construir um cérebro robótico semelhante ao ChatGPT, que ajude robôs a realizar tarefas em novos ambientes sem a necessidade de demonstração humana.

“Com o Diffusion Forcing, estamos dando um passo para aproximar a geração de vídeos e a robótica”, afirma Vincent Sitzmann, professor assistente do MIT e membro do CSAIL, onde lidera o grupo de Representação de Cena. “Esperamos que possamos usar todo o conhecimento armazenado em vídeos na internet para capacitar robôs a ajudar na vida cotidiana. Muitos desafios de pesquisa emocionantes ainda permanecem, como descobrir como os robôs podem aprender a imitar humanos apenas assistindo a eles, mesmo quando seus próprios corpos são tão diferentes dos nossos!”

Redação Confraria Tech.

Referências:

Combining next-token prediction and video diffusion in computer vision and robotics