Imagine um robô chegando em um armazém. Ele chega com as habilidades nas quais foi treinado, como colocar um objeto, e agora precisa pegar itens de uma prateleira com a qual não está familiarizado. Inicialmente, a máquina tem dificuldades com isso, pois precisa se familiarizar com seu novo ambiente. Para melhorar, o robô precisará entender em quais habilidades dentro de uma tarefa geral precisa de aprimoramento e, em seguida, especializar (ou parametrizar) essa ação.

Um humano no local poderia programar o robô para otimizar seu desempenho, mas pesquisadores do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) do MIT e do Instituto de Inteligência Artificial desenvolveram uma alternativa mais eficaz. Apresentado na Conferência de Robótica: Ciência e Sistemas no mês passado, o algoritmo “Estimate, Extrapolate, and Situate” (EES) permite que essas máquinas pratiquem por conta própria, potencialmente ajudando-as a melhorar em tarefas úteis em fábricas, residências e hospitais.

Avaliando a situação

Para ajudar os robôs a melhorarem em atividades como varrer o chão, o EES trabalha com um sistema de visão que localiza e rastreia o ambiente da máquina. Em seguida, o algoritmo estima o quão confiavelmente o robô executa uma ação (como varrer) e se valeria a pena praticar mais. O EES prevê quão bem o robô poderia executar a tarefa geral se aprimorasse aquela habilidade específica e, finalmente, pratica. O sistema de visão verifica posteriormente se essa habilidade foi executada corretamente após cada tentativa.

O EES poderia ser útil em lugares como hospitais, fábricas, casas ou cafeterias. Por exemplo, se você quisesse que um robô limpasse sua sala de estar, ele precisaria de ajuda para praticar habilidades como varrer. Segundo Nishanth Kumar SM ’24 e seus colegas, no entanto, o EES poderia ajudar o robô a melhorar sem intervenção humana, usando apenas algumas tentativas de prática.

“Fomos para este projeto pensando se essa especialização seria possível em uma quantidade razoável de amostras em um robô real”, diz Kumar, co-autor principal de um artigo descrevendo o trabalho, estudante de doutorado em engenharia elétrica e ciência da computação e afiliado ao CSAIL. “Agora, temos um algoritmo que permite que os robôs melhorem significativamente em habilidades específicas em um tempo razoável com dezenas ou centenas de pontos de dados, uma melhoria em relação às milhares ou milhões de amostras que um algoritmo padrão de aprendizado por reforço requer”.

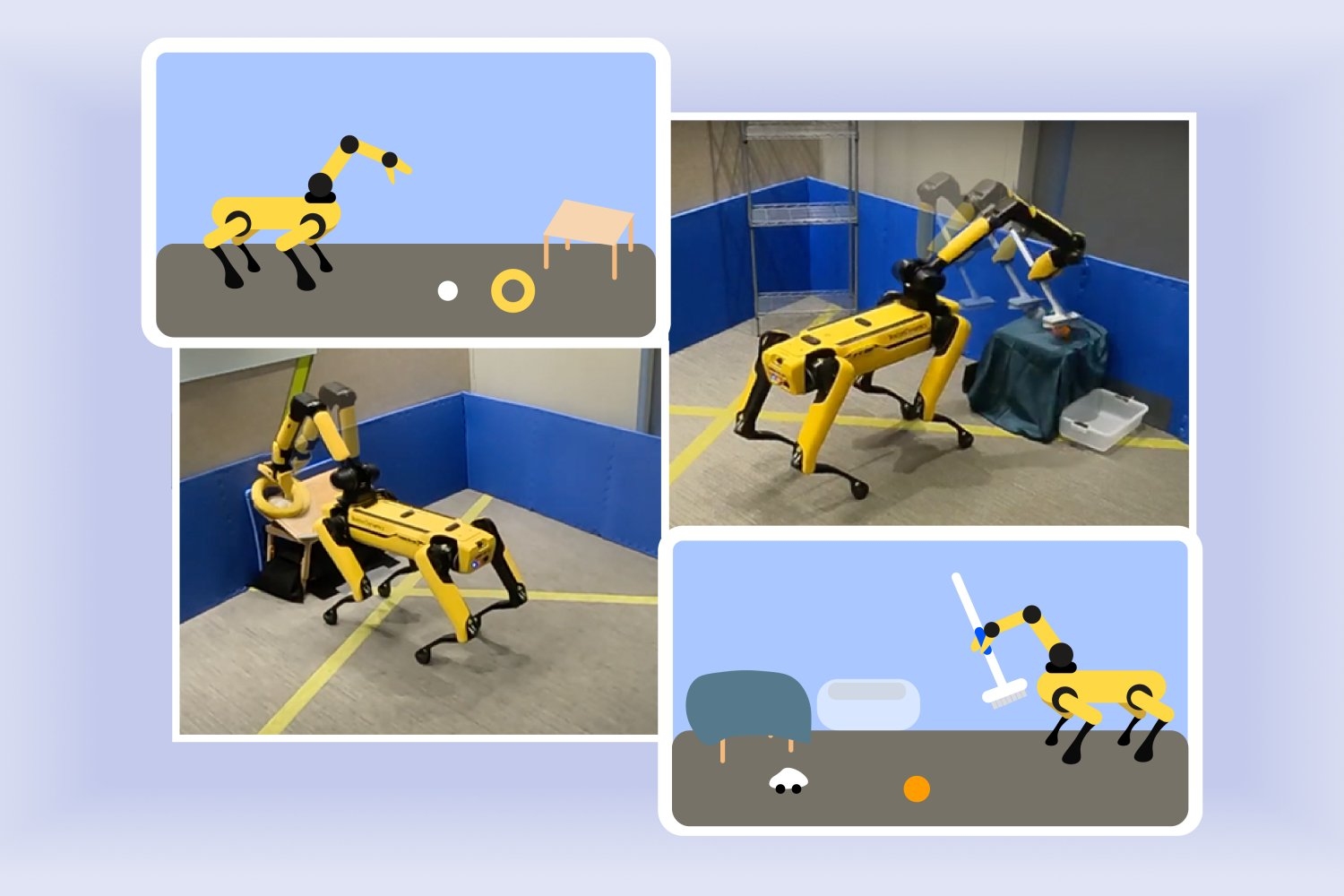

EES’s habilidade para uma aprendizagem eficiente foi evidente quando implementada no quadrúpede Spot da Boston Dynamics durante testes de pesquisa no Instituto de Inteligência Artificial. O robô, que tem um braço preso às costas, completou tarefas de manipulação após praticar por algumas horas. Em uma demonstração, o robô aprendeu a colocar uma bola e um anel de forma segura em uma mesa inclinada em cerca de três horas. Em outro, o algoritmo guiou a máquina para melhorar a maneira de varrer brinquedos em um recipiente em cerca de duas horas. Ambos os resultados parecem ser uma melhoria em relação a estruturas anteriores, que provavelmente teriam levado mais de 10 horas por tarefa.

“Nosso objetivo era que o robô coletasse sua própria experiência para que possa escolher melhor quais estratégias funcionarão bem em seu ambiente”, diz o co-autor principal Tom Silver SM ’20, PhD ’24, um ex-aluno de engenharia elétrica e ciência da computação (EECS) e afiliado do CSAIL que agora é professor assistente na Universidade de Princeton. “Ao focarmos no que o robô sabe, procuramos responder a uma pergunta-chave: Na biblioteca de habilidades que o robô tem, qual é a mais útil para praticar agora?

EES eventualmente poderia ajudar a otimizar a prática autônoma para robôs em novos ambientes de implantação, mas, por enquanto, vem com algumas limitações. Para começar, eles usaram mesas baixas, o que facilitou para o robô ver seus objetos. Kumar e Silver também imprimiram em 3D uma alça que tornou a escova mais fácil para o Spot pegar. O robô não detectou alguns itens e identificou objetos nos lugares errados, então os pesquisadores contaram esses erros como falhas.

Dando lição de casa aos robôs

Os pesquisadores observam que a velocidade de prática dos experimentos físicos poderia ser acelerada ainda mais com a ajuda de um simulador. Em vez de trabalhar fisicamente em cada habilidade autonomamente, o robô eventualmente poderia combinar prática real e virtual. Eles esperam tornar seu sistema mais rápido com menos latência, projetando o EES para superar os atrasos de imagem que os pesquisadores experimentaram. No futuro, eles podem investigar um algoritmo que raciocine sobre sequências de tentativas de prática em vez de planejar quais habilidades aprimorar.

“Permitir que os robôs aprendam por conta própria é extremamente útil e extremamente desafiador”, diz Danfei Xu, professor assistente na Escola de Computação Interativa da Georgia Tech e cientista pesquisador na NVIDIA AI, que não estava envolvido com este trabalho. “No futuro, os robôs domésticos serão vendidos para todos os tipos de casas e esperados para executar uma ampla gama de tarefas. Não podemos programar tudo o que eles precisam saber antecipadamente, então é essencial que possam aprender durante o trabalho. No entanto, liberar os robôs para explorar e aprender sem orientação pode ser muito lento e levar a consequências não intencionais. A pesquisa de Silver e seus colegas introduz um algoritmo que permite que os robôs pratiquem suas habilidades autonomamente de maneira estruturada. Este é um grande passo para criar robôs domésticos que possam evoluir e melhorar continuamente por conta própria.”

Os coautores de Silver e Kumar são os pesquisadores do Instituto de Inteligência Artificial Stephen Proulx e Jennifer Barry, além de quatro membros do CSAIL: o aluno de doutorado da Northeastern University e pesquisador visitante Linfeng Zhao, o aluno de doutorado da MIT EECS Willie McClinton e os professores da MIT EECS Leslie Pack Kaelbling e Tomás Lozano-Pérez. Seu trabalho foi apoiado, em parte, pelo Instituto de Inteligência Artificial, pela National Science Foundation dos EUA, pelo U.S. Air Force Office of Scientific Research, pelo U.S. Office of Naval Research, pelo U.S. Army Research Office e pelo MIT Quest for Intelligence, com recursos de computação de alto desempenho do MIT SuperCloud e do Lincoln Laboratory Supercomputing Center.

Redação Confraria Tech

Referências:

Helping robots practice skills independently to adapt to unfamiliar environments