Já lhe fizeram uma pergunta para a qual você só sabia parte da resposta? Para dar uma resposta mais informada, a melhor opção seria ligar para um amigo com mais conhecimento sobre o assunto.

Esse processo colaborativo também pode ajudar os grandes modelos de linguagem (LLMs) a melhorar sua precisão. No entanto, tem sido difícil ensinar aos LLMs o reconhecimento de quando devem colaborar com outro modelo em uma resposta. Em vez de usar fórmulas complexas ou grandes quantidades de dados rotulados para explicar onde os modelos devem trabalhar juntos, os pesquisadores do Laboratório de Ciência da Computação e Inteligência Artificial do MIT (CSAIL) imaginaram uma abordagem mais orgânica.

Seu novo algoritmo, chamado “Co-LLM”, pode associar um LLM de propósito geral a um modelo mais especializado e ajudá-los a trabalhar juntos. Enquanto o primeiro elabora uma resposta, o Co-LLM revisa cada palavra (ou token) dentro de sua resposta para ver onde pode recorrer a uma resposta mais precisa do modelo especialista. Esse processo leva a respostas mais precisas para coisas como solicitações médicas e problemas de matemática e raciocínio. Como o modelo especialista não é necessário em cada iteração, isso também leva a uma geração de respostas mais eficiente.

Para decidir quando um modelo base precisa de ajuda de um modelo especialista, o framework usa aprendizado de máquina para treinar uma “variável de troca”, ou uma ferramenta que pode indicar a competência de cada palavra nas respostas dos dois LLMs. A variável de troca é como um gerente de projeto, encontrando áreas onde deve chamar um especialista. Se você pedisse ao Co-LLM para citar alguns exemplos de espécies de ursos extintas, por exemplo, dois modelos elaborariam respostas juntos. O LLM de propósito geral começa a elaborar uma resposta, com a variável de troca intervindo nas partes onde pode inserir um token melhor do modelo especialista, como adicionar o ano em que a espécie de urso se extinguiu.

“Com o Co-LLM, estamos essencialmente treinando um LLM de propósito geral para ‘ligar’ para um modelo especialista quando necessário”, diz Shannon Shen, uma estudante de doutorado do MIT em engenharia elétrica e ciência da computação e afiliada ao CSAIL que é autora principal de um novo artigo sobre a abordagem. “Usamos dados específicos do domínio para ensinar o modelo base sobre a expertise de seu parceiro em áreas como tarefas biomédicas e questões de matemática e raciocínio. Esse processo encontra automaticamente as partes dos dados que são difíceis para o modelo base gerar e, em seguida, instrui o modelo base a mudar para o LLM especialista, que foi pré-treinado em dados de um campo similar. O modelo de propósito geral fornece a geração ‘andaime’, e quando chama o LLM especializado, ele solicita que o especialista gere os tokens desejados. Nossas descobertas indicam que os LLMs aprendem padrões de colaboração organicamente, assemelhando-se a como os humanos reconhecem quando devem chamar um especialista para preencher as lacunas.”

Uma combinação de flexibilidade e factualidade

Imagine pedir a um LLM de propósito geral para citar os ingredientes de um medicamento específico. Ele pode responder incorretamente, necessitando da expertise de um modelo especializado.

Para mostrar a flexibilidade do Co-LLM, os pesquisadores usaram dados como o conjunto médico BioASQ para acoplar um LLM base com LLMs especializados em diferentes domínios, como o modelo Meditron, que é pré-treinado em dados médicos não rotulados. Isso permitiu que o algoritmo ajudasse a responder a perguntas que um especialista em biomedicina normalmente receberia, como citar os mecanismos que causam uma doença específica.

Por exemplo, se você pedisse a um simples LLM sozinho para citar os ingredientes de um medicamento específico, ele poderia responder incorretamente. Com a expertise adicional de um modelo especializado em dados biomédicos, você obteria uma resposta mais precisa. O Co-LLM também alerta os usuários sobre onde verificar as respostas.

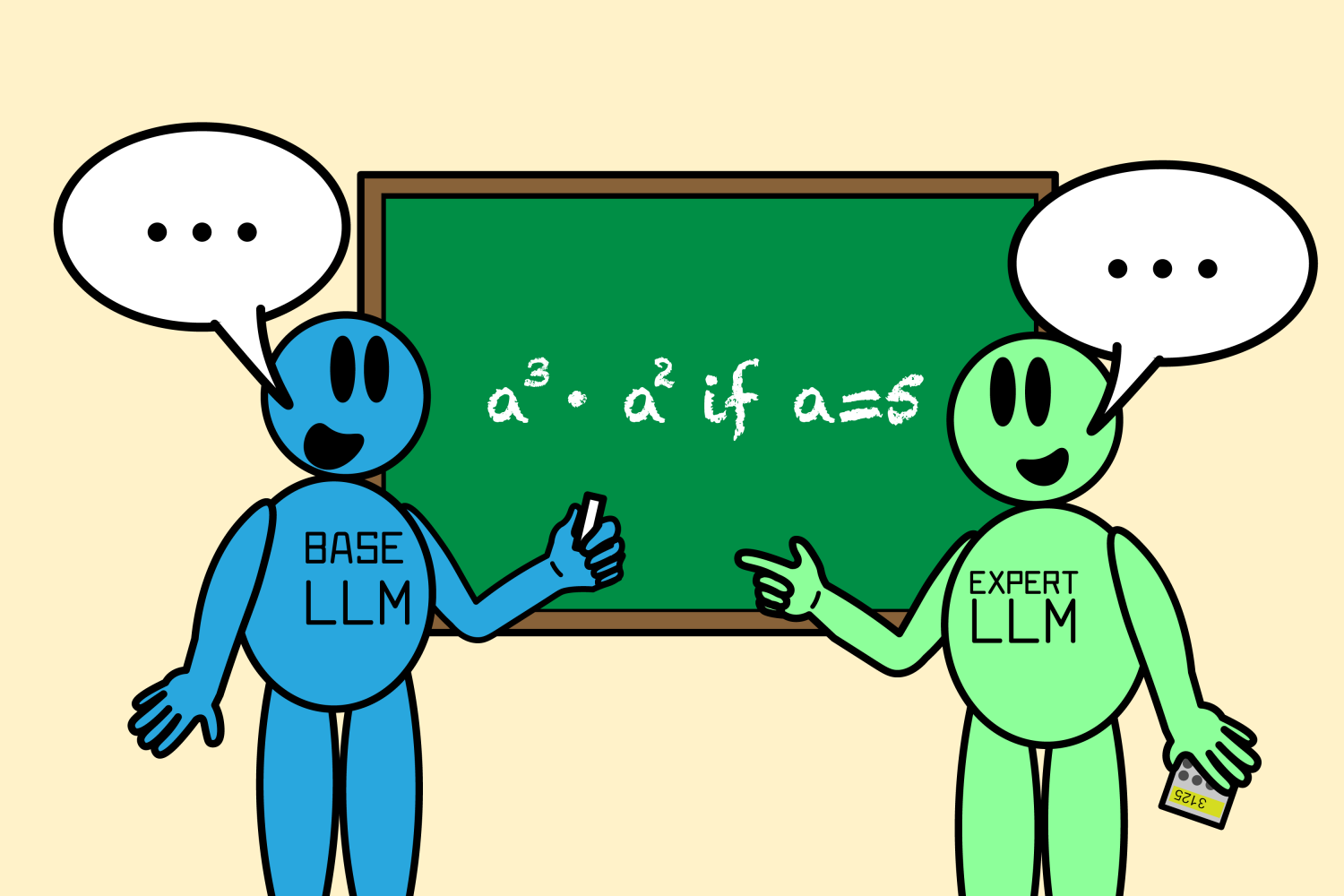

Outro exemplo do aumento de desempenho do Co-LLM: ao ser encarregado de resolver um problema de matemática como “a3 · a2 se a=5”, o modelo de propósito geral calculou incorretamente a resposta como sendo 125. Conforme o Co-LLM treinou o modelo para colaborar mais com um grande LLM de matemática chamado Llemma, juntos determinaram que a solução correta era 3.125.

O Co-LLM forneceu respostas mais precisas do que os LLMs simples ajustados e os modelos especializados não ajustados trabalhando independentemente. O Co-LLM pode orientar dois modelos treinados de forma diferente a trabalhar juntos, enquanto outras abordagens eficazes de colaboração de LLM, como “Ajuste de Proxy”, precisam que todos os seus modelos componentes sejam treinados de forma semelhante. Além disso, esse método de referência exige que cada modelo seja usado simultaneamente para produzir a resposta, enquanto o algoritmo do MIT simplesmente ativa seu modelo especialista para tokens específicos, levando a uma geração mais eficiente.

Quando pedir ajuda ao especialista

O algoritmo dos pesquisadores do MIT destaca que imitar mais de perto o trabalho em equipe humano pode aumentar a precisão na colaboração de vários LLMs. Para elevar ainda mais sua precisão factual, a equipe pode se inspirar na autodecorreção humana: eles estão considerando uma abordagem de adiamento mais robusta que pode retroceder quando o modelo especialista não dá uma resposta correta. Essa atualização permitiria ao Co-LLM corrigir o curso para que o algoritmo ainda possa fornecer uma resposta satisfatória.

A equipe também gostaria de atualizar o modelo especialista (via treinamento apenas do modelo base) quando novas informações estiverem disponíveis, mantendo as respostas o mais atualizadas possível. Isso permitiria que o Co-LLM associasse as informações mais recentes com um forte poder de raciocínio. Eventualmente, o modelo poderia ajudar com documentos empresariais, usando as informações mais recentes que possui para atualizá-los adequadamente. O Co-LLM também poderia treinar modelos pequenos e privados para trabalhar com um LLM mais poderoso para melhorar documentos que devem permanecer no servidor.

“O Co-LLM apresenta uma abordagem interessante para aprender a escolher entre dois modelos para melhorar eficiência e desempenho”, diz Colin Raffel, professor associado na Universidade de Toronto e diretor de pesquisa associado no Vector Institute, que não esteve envolvido na pesquisa. “Como as decisões de roteamento são tomadas no nível do token, o Co-LLM fornece uma maneira granular de adiar etapas difíceis de geração para um modelo mais poderoso. A combinação única de roteamento de modelo-token também fornece uma grande flexibilidade que métodos similares não possuem. O Co-LLM contribui para uma linha importante de trabalho que visa desenvolver ecossistemas de modelos especializados para superar sistemas de IA monolíticos caros.”

Shen escreveu o artigo com outros quatro afiliados do CSAIL: o estudante de doutorado Hunter Lang ’17, MEng ’18; o ex-pós-doutor e pesquisador de IA/ML da Apple Bailin Wang; Yoon Kim, professor assistente do MIT em engenharia elétrica e ciência da computação, e David Sontag, professor e membro da Jameel Clinic, que fazem parte do MIT-IBM Watson AI Lab. Sua pesquisa foi apoiada, em parte, pela National Science Foundation, pela National Defense Science and Engineering Graduate (NDSEG) Fellowship, pelo MIT-IBM Watson AI Lab e pela Amazon. Seu trabalho foi apresentado na Reunião Anual da Associação de Linguística Computacional.

Redação Confraria Tech.

Referências:

Enhancing LLM collaboration for smarter, more efficient solutions